Weer een blog over AI? Jazeker, maar dit keer geen hoogover beleidsstuk; alleen concrete en toepasbare informatie. Geschreven op basis van echte ervaringen met interne en klantgerichte AI-oplossingen. Deze blog helpt je om een AI-aanpak te kiezen en mogelijke investeringen te doen die passen bij jouw organisatie.

Eerst laten we zien hoe AI in de financiële dienstverlening vandaag al rendement oplevert. We bespreken twee sleuteltechnologieën: retrieval-augmented generation (RAG) en het model context protocol (MCP). Daarnaast delen we actuele cijfers, zowel Europese als Nederlandse voorbeelden, en sluiten we af met een stappenplan.

Banken en verzekeraars voelen de druk: klanten verwachten realtime service, toezichthouders verhogen de eisen en nieuwe spelers betreden de markt met digitale oplossingen. Veel bestuurders en managers weten dat kunstmatige intelligentie waardevol kan zijn, maar worstelen met de vraag: hoe pas ik AI concreet toe zonder te verdwalen in de hype en de beveiligingsrisico’s?

AI-ontwikkeling en toepassing in financiële dienstverlening

AI is niet langer een experiment. Waar vroege toepassingen vooral draaiden om eenvoudige chatbots, zien we nu dat AI diep ingrijpt in riskmanagement, compliance en klantbediening. McKinsey schat de jaarlijkse waarde van AI in banking & insurance op 200 tot 340 miljard dollar.

Roger Hendriks, CTO bij Fenêtre, vertelt:

“Binnen ons bedrijf werkt inmiddels iedereen dagelijks één of meerdere keren met AI, van officemanager tot developer. We geloven in AI en zien dit niet als de volgende hype. Onze slagkracht en kwaliteit stijgen gestaag met dezelfde bezetting.”

Het gaat hierbij vooral om méér realiseren met dezelfde mensen, in plaats van hetzelfde blijven doen met minder mensen. Met de nuance dat de markt voor een IT-bedrijf zoals Fenêtre relatief schaalbaar is, en dat geldt niet voor elke organisatie. In sectoren waar de groei beperkt is, ligt de echte kracht in sterker en slimmer werken.

Standaardpakketten vs. maatwerkoplossingen

Kies je voor een standaard oplossing of toch voor custom? Eric Kruis, CEO bij Fenêtre, verwoordt het als volgt:

“Net als bij maatwerk applicaties geldt bij AI-oplossingen ook: hoe meer toegespitst de oplossing, hoe groter meerwaarde tegenover je concurrenten. Kies je voor standaard dan is zeker meerwaarde; ga je richting maatwerk dan kan de meerwaarde enorm zijn. We zien dat mkb-bedrijven soms opzien tegen de moeite en investering bij maatwerkoplossingen."

De 2 AI-mogelijkheden voor bedrijven

Wil je AI-software toepassen, dan zijn er volgens Roger Hendriks grofweg twee mogelijkheden: "Er zijn standaardoplossingen zoals Microsoft Copilot for Business en ChatGPT of juist een ‘eigen’ chatmodule in de cloud."

1. Standaard oplossingen zoals Microsoft Copilot for Business en ChatGPT.

Deze oplossingen zijn direct beschikbaar en bieden integratie met Microsoft 365 en andere veelgebruikte bedrijfsapplicaties. Voor Europese bedrijven kleven er echter nadelen aan: deze diensten vallen onder Amerikaanse jurisdictie, met de mogelijkheid van inzage door de overheid van de VS. Voor EU-bedrijven biedt OpenAI inmiddels data residency, maar dat geldt (nog) niet voor de veelgebruikte Teams-variant.

Daarnaast zijn er al security-issues gemeld bij beide oplossingen. Ook ontbreekt de mogelijkheid tot uitgebreide fine-tuning voor bedrijfsspecifieke wensen. Dit kan Nederlandse bedrijven huiverig maken om deze oplossingen te adopteren. Wat betreft de kosten: in augustus bedroeg het tarief voor ChatGPT Teams € 29,- per gebruiker per maand. Voor een bedrijf met 200 medewerkers betekent dit een maandelijkse uitgave van € 5.800.

2. Een ‘eigen’ AI-chatmodule, opensource in de cloud

Een open source of custom chatmodule biedt meer flexibiliteit, sluit beter aan op specifieke bedrijfsprocessen en kan op termijn goedkoper uitpakken. Zo’n maatwerkmodule wordt gekoppeld aan een cloud-based Large Language Model (LLM) en een lokale MCP-server (zie toelichting hieronder).

De voordelen hiervan zijn duidelijk: veel meer controle, antwoorden die worden onderbouwd met eigen bedrijfsdata en volledige AVG-conformiteit zonder risico op Amerikaanse inzage, mits gekozen wordt voor een Europese cloudleverancier.

Eric maakt het concreet: “De initiële investering ligt hoger, denk aan € 30-40k voor een chatmodule met enkele MCP servers, maar de besparing op abonnementskosten zijn substantieel. Een rekenvoorbeeld: Voor 200 man met gemiddeld 10 chats per dag met elk 5 vragen kan dit, ruim genomen, uitkomen op € 250,- per maand bij een goed open-source model. Een externe hosting van de chatmodule kost circa € 3k per jaar. Dus ruim genomen komen we op € 46k voor het eerste jaar. Dat verdient zich voor 200 medewerkers snel terug. En met technieken als RAG en MCP ontsluit je je eigen data veilig en flexibel met beter passende antwoorden.”

Van informatie naar actie: RAG en MCP uitgelegd

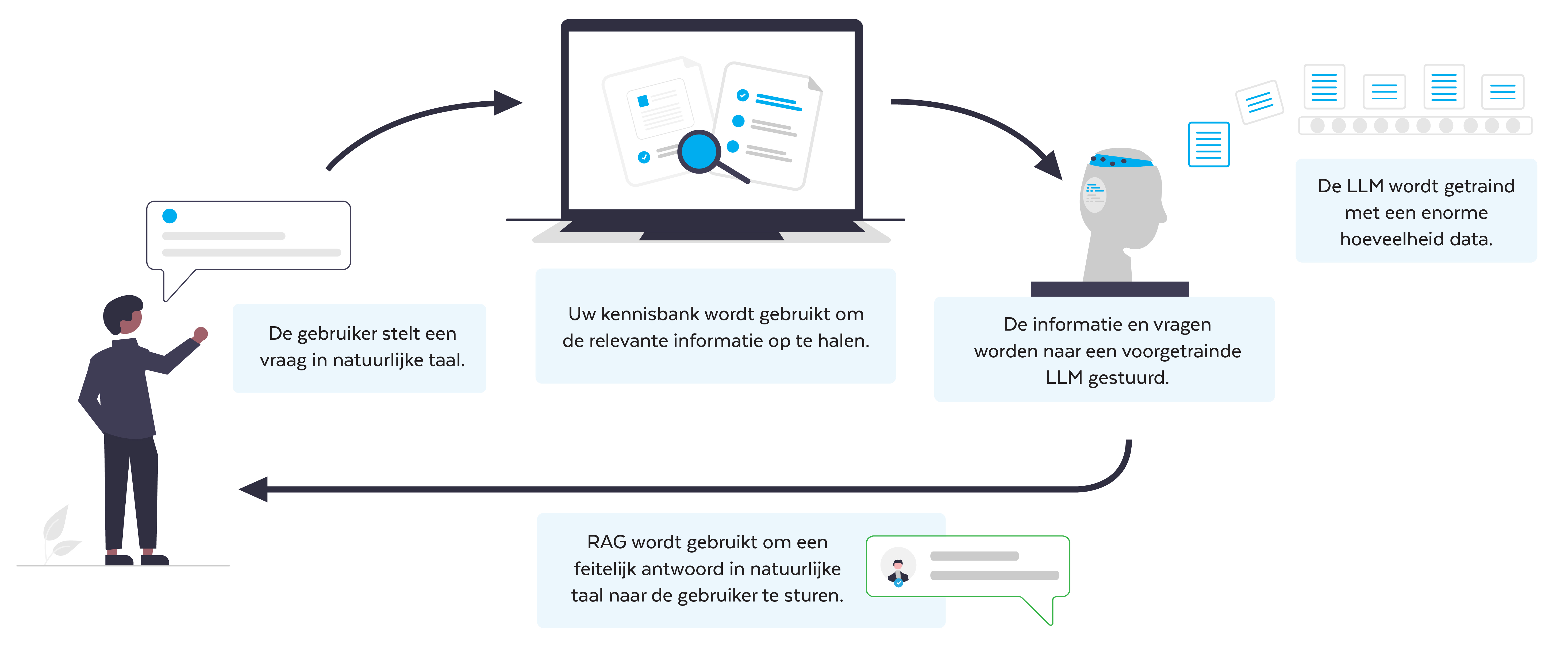

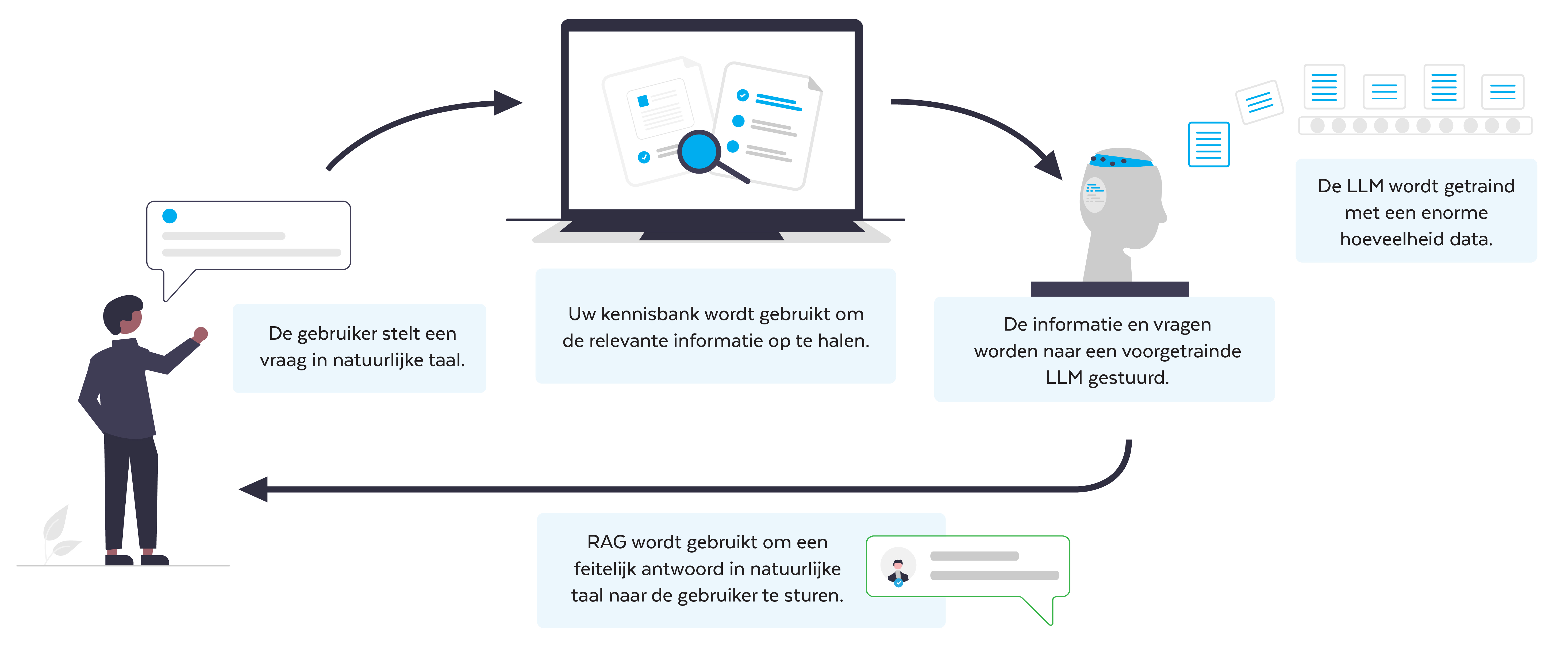

Wat is RAG?

Retrieval-Augmented Generation (RAG) koppelt een taalmodel aan een databron. Een klant vraagt of zijn verzekering natuurschade dekt. In plaats van een generiek antwoord, haalt RAG eerst het juiste polisdocument op en baseert daarop het antwoord. Dat maakt AI transparant en verifieerbaar.

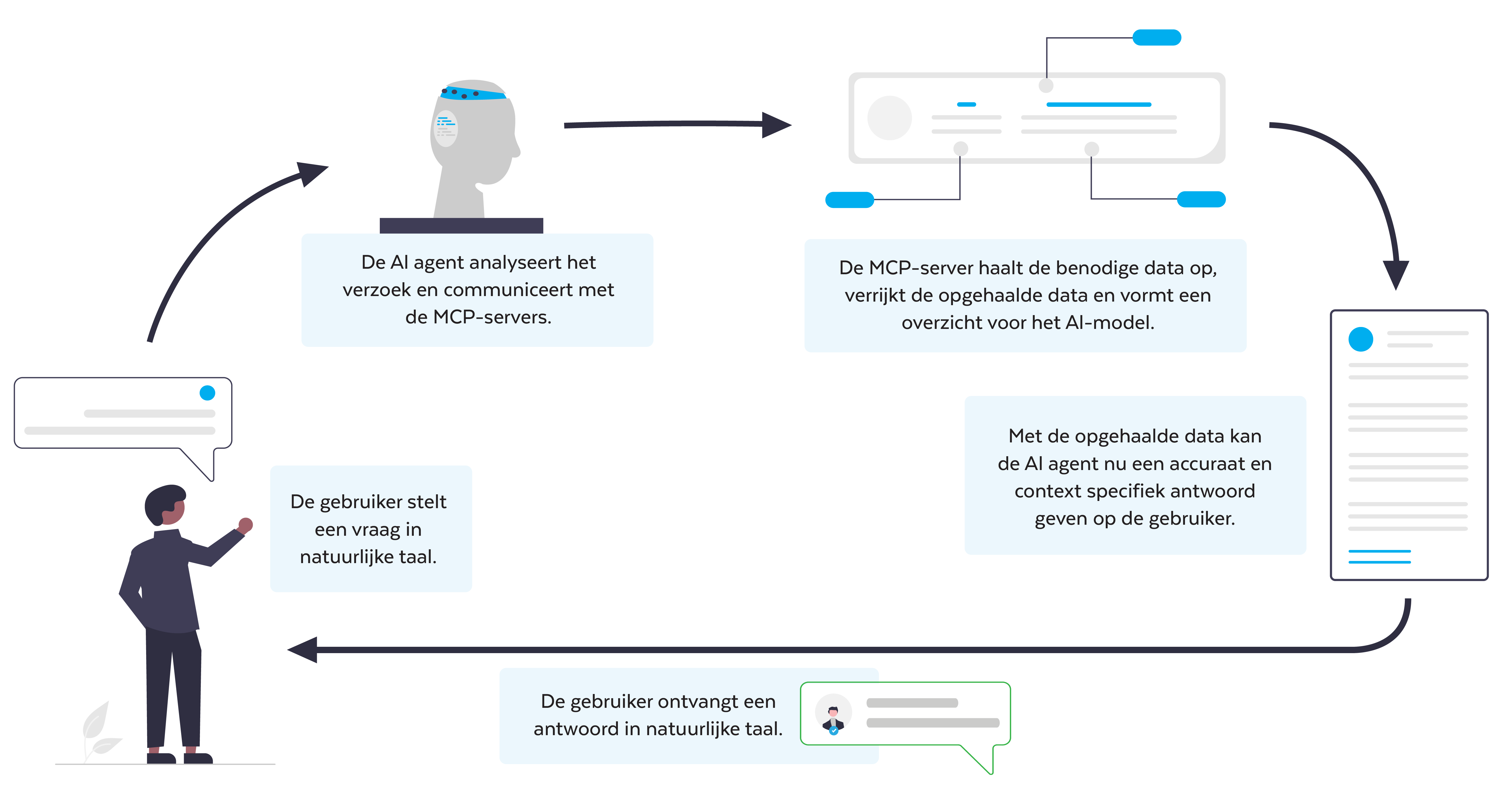

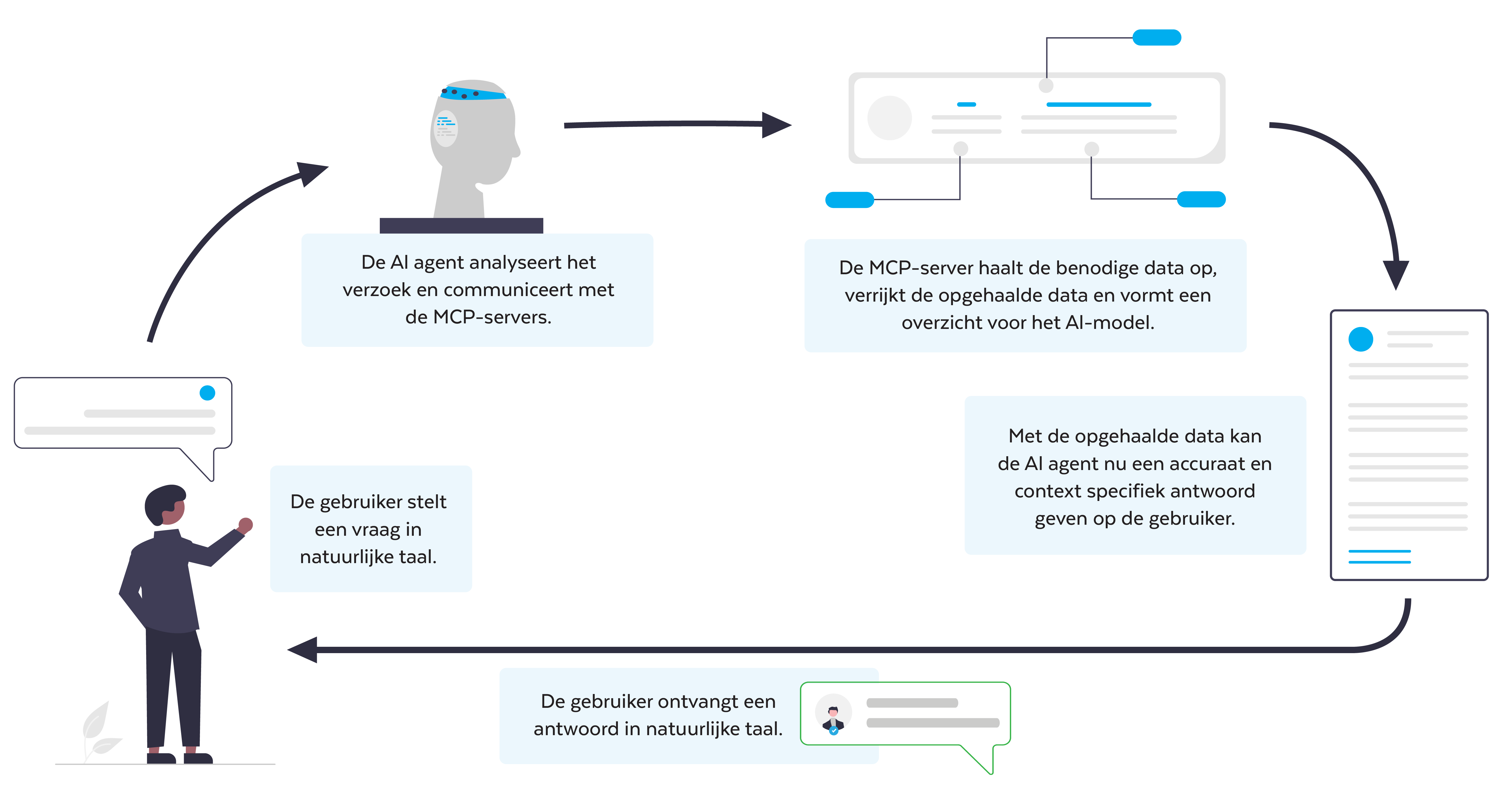

Wat is MCP?

Het Model Context Protocol (MCP) is een open-source standaard om gestructureerde data, zoals database-records, wiki’s en API-info, veilig te koppelen aan Large Language Models. Zo combineert je chatbot LLM-taalkennis met jouw eigen informatie en levert hij onderbouwde antwoorden.

Bij beide toepassingen bepaal precies welke data gedeeld zal worden, wat zorgt voor hogere veiligheid en beter toepasbare antwoorden, met uitsluitend de data die jij wilt delen.”

De Europese en Nederlandse context

De helft van de schadeverzekeraars en een kwart van de levensverzekeraars zet AI al in. Maar generatieve AI kan in de Europese financiële sector nóg meer extra waarde opleveren. Uit een presentatie van de ABI (UK) blijkt dat generatieve AI en LLMs steeds meer geïntegreerd worden in klant- en claimsprocessen binnen de sector.

In Nederland zien we dat banken en verzekeraars volop experimenteren. Zorgen over privacy en uitlegbaarheid remmen vaak toch de schaalgroei. Juist technieken als RAG en MCP bieden hier uitkomst: ze maken AI transparant, herleidbaar en veiliger.

Wat zijn de concrete toepassingen van AI in financiële dienstverlening?

Binnen de verzekeringswereld zijn veel gegevens aanwezig, gegevens die voor allerlei doeleinden gebruikt kunnen worden om, met inzet van AI, doorlooptijden te versnellen, kwaliteit verhogen en compliance aan te scherpen. Voorbeelden van processen waarbij AI direct waarde kan leveren:

- Claimcontroles en voorspellingen.

- Fraudesignalen detecteren.

- Genereren van polissen en wijzigingsvoorstellen op basis van producten en historie.

- Voorstellen voor premieberekening.

- Zoeken en toepassen van complexe clausules.

Hoe ga jij verder? Een stappenplan op basis van waar je nu staat

Wat is de juiste AI-aanpak? Hoe nu verder? Hendriks en Kruis schetsen een aantal scenario's en mogelijke stappen:

1. Je gebruikt AI nu ad hoc

“Een eenvoudige stap is dan om elke medewerker een betaalde, beheerde licentie van Microsoft 365 Copilot of ChatGPT Teams te geven om te standaardiseren en dataverlies bij de gratis varianten te vermijden. Richt een implementatieproces in met voortrekkersrollen, duidelijke do’s & don’ts en korte trainingen.”

2. Je gebruikt AI nu gestructureerd met standaard producten

“Ben je al een stap verder en wil je meer compliance, en antwoorden die beter passen bij jouw organisatie tegen een lagere TCO? Overweeg een custom chat gekoppeld aan een MCP-server. Blijf je bij de standaardoplossingen dan kun je onderzoeken hoe de agentmogelijkheden werken en hoe te koppelen aan extra databronnen.”

3. Je bent al bezig met gespecialiseerde ontsluiting van eigen gegevens

“Breng je AI-omgeving op een nog hoger niveau met contra-expertise of gericht advies over bijvoorbeeld de gebruikte architectuur, RAG-opties en security-aspecten.”

“Voor alle stappen geldt”, zo besluit Kruis, “een helder implementatieplan met bijbehorende voortrekkers en gerichte trainingen zijn dé randvoorwaarden voor duurzaam succes. En vooral: borg privacy, beveiliging en controleerbaarheid vanaf dag één.”

Persoonlijk advies ontvangen? Ontdek hoe jouw organisatie slimmer kan werken, zonder verdwaald te raken in complexe AI-projecten.

Neem nu contact op